虚拟上网卡设备

上网卡设备 时间:2021-05-22 阅读:()

RDMA虚拟化相关技术研究①代超1,刘强1,蒋金虎2,张为华21(复旦大学软件学院,上海201203)2(复旦大学上海市数据科学重点实验室,上海201203)通讯作者:张为华,E-mail:zhangweihua@fudan.

edu.

cn摘要:RDMA网络具有高带宽,低延时,低CPU负载的特点,广泛应用于数据密集型任务中,例如深度学习,高性能计算,数据分析等.

RDMA的实现需要软硬件支持,在云环境下,RDMA虚拟化方案有助于多用户共享RDMA网络传输的高性能,同时实现对RDMA网络的统一管理和控制.

本文调研了近年来的RDMA虚拟化解决方案,覆盖了虚拟机和容器环境;然后将这些解决方案进行分类和比较;最后,对RDMA虚拟化中存在的问题和未来的发展做出了总结和展望.

关键词:RDMA;虚拟化;云计算引用格式:代超,刘强,蒋金虎,张为华.

RDMA虚拟化相关技术研究.

计算机系统应用,2020,29(10):1–8.

http://www.

c-s-a.

org.

cn/1003-3254/7637.

htmlSurveyonRDMAVirtualizationTechnologyDAIChao1,LIUQiang1,JIANGJin-Hu2,ZHANGWei-Hua21(SoftwareSchool,FudanUniversity,Shanghai201203,China)2(ShanghaiKeyLaboratoryofDataScience,FudanUniversity,Shanghai201203,China)Abstract:RDMAnetworkshavethecharacteristicsofhighbandwidth,lowlatency,andlowCPUload,andareusedinawiderangeofdata-intensivetasks,suchasdeeplearning,high-performancecomputing,anddataanalysis.

Theimple-mentationofRDMArequiressoftwareandhardwaresupport.

Inacloudenvironment,theRDMAvirtualizationsolutionshelpmultipleuserstosharethehighperformanceofRDMAnetwork,whileachievingunifiedmanagementofRDMAnetworks.

Inthisstudy,solutionsofRDMAvirtualizationinrecentyearsarecollected,whichcovervirtualma-chinesandcontainerenvironments.

Then,thesesolutionsareclassifiedandcompared.

Finally,theexistingproblemsandfuturedevelopmentinRDMAvirtualizationareanalyzed.

Keywords:RDMA;virtualization;cloudcomputing1引言随着互联网技术的快速发展,应用的用户规模越来越大,需要的服务器资源越来越多.

传统服务器部署和维护成本高,资源利用率低,难以跟上互联网应用的发展需求.

为了实现对服务器资源的高效利用,满足大规模用户的需求,亚马逊最早于2006年推出了弹性云计算服务.

云计算将服务器硬件资源,例如CPU,内存,网络等进行虚拟化,以按需使用的方式提供给多用户使用.

目前,云计算已经引起了学界和业界的高度重视,例如,谷歌、微软、阿里巴巴和腾讯等企业也竞相发布了各种云计算平台.

虚拟化技术广泛应用于云计算,模拟器,安全,分析等领域[1–6].

虚拟机相关的虚拟化技术包括CPU虚拟化,内存虚拟化,I/O虚拟化等.

虚拟化技术可以分为硬计算机系统应用ISSN1003-3254,CODENCSAOBNE-mail:csa@iscas.

ac.

cnComputerSystems&Applications,2020,29(10):18[doi:10.

15888/j.

cnki.

csa.

007637]http://www.

c-s-a.

org.

cn中国科学院软件研究所版权所有.

Tel:+86-10-62661041①基金项目:国家自然科学基金(61672160)Foundationitem:NationalNaturalScienceFoundationofChina(61672160)收稿时间:2020-03-10;修改时间:2020-04-10;采用时间:2020-04-21;csa在线出版时间:2020-09-30SpecialIssue专论综述1件辅助的虚拟化和软件辅助的虚拟化等.

容器也是目前流行的虚拟化方案.

区别于虚拟机,容器通过Linux的命名空间和控制组机制,让应用程序在独立的运行时环境执行,具有轻量级隔离和可移植的特点.

目前,流行的容器引擎有Docker[7],RKT[8]等.

RDMA(RemoteDirectMemoryAccess)是一种高速网络传输技术,传输数据时可以绕过操作系统直接对远端内存进行读写.

相较于传统的TCP/IP网络,RDMA具有低延迟,高吞吐,低CPU负载的特点,更适合数据中心的网络传输需求.

目前,RDMA广泛应用于云计算系统和大数据平台的网络密集型任务,例如TensorFlow[9]、Spark[10]、Hadoop[11]等.

RDMA技术提供了高性能的网络传输,虚拟机和容器技术提供了云计算用户隔离,共享物理资源以及灵活管理的特点.

RDMA虚拟化技术的目标就是将云环境的特点与RDMA网络的高性能特点相结合,以满足云计算用户对可靠的高性能RDMA网络传输服务的需求.

本文调研了近年来RDMA虚拟化的主要解决方案,覆盖了虚拟机和容器的云计算环境,对相关技术进行了系统全面的分析和讨论.

在此基础上,对现有RDMA虚拟化技术进行了总结,对存在的问题进行了探讨和展望.

2RDMA介绍RDMA是一种远程直接访问内存的网络技术.

RDMA的出现是为了解决数据中心网络传输的延迟问题.

在使用RDMA连接时,主机可以直接绕过双方的操作系统,对远端主机的内存进行读写,从而避免经过内核时数据拷贝的开销,同时不占用CPU资源.

因此,相较于传统的TCP/IP网络,RDMA具有低延迟,高吞吐,低CPU负载的特点,更适合数据中心的网络传输需求.

目前,RDMA广泛应用于人工智能、高性能计算、大数据分析和分布式存储等领域.

TensorFlow、PaddlePaddle[12]等流行深度学习框架均支持RDMA;根据2019年11月份的HPCtop500统计[13],排名前10的超算系统有6个使用了200Gb/sInfiniBand[14](一种RDMA网络),500强名单中使用该网络的超算系统达到了140个;大数据分析框架Spark、Hadoop等均有用到RDMA的成熟方案;在分布式存储系统领域,键值对系统、文件系统、分布式事务等也都利用了RDMA网络特性[15],例如键值对系统Pilaf[16]、文件系统Octopus[17]以及分布式事务系统DrTM[18]、FaRM[19]等.

如图1所示,应用通过调用统一的Verbs[20]接口来进行RDMA网络传输.

完整的RDMA传输过程具有控制路径和数据路径.

首先,在控制路径上建立连接,两端的RDMA应用在各自的网卡上创建QP(QueuePairs)和CQ(CompleteQueue),并完成内存注册.

QP和CQ均映射到应用的地址空间,其中,QP由接收队列和发送队列组成,应用通过它们控制RDMA传输,而CQ负责提供任务完成的通知.

然后,两端应用的QP通过交换信息来完成配对.

当连接建立后,在数据路径上,应用可以绕过内核,直接通过QP请求网卡将内存数据以DMA(DirectMemoryAccess)方式读取到网卡缓冲并发送给远端,或者将网卡缓冲中接收的远端数据以DMA方式写入本地内存.

图1RDMA通信RDMA有Write/Read和Send/Recv两种通信方式.

Write/Read是单边操作,读(写)方不需要事先通知对方,在建立连接后直接读(写)远端服务中RDMA应用内存地址中的数据.

例如,在建立RDMA连接后,应用调用Write命令,根据远端提供的虚拟机地址,直接通过RDMA网卡进行数据传输.

Send/Recv是双边操作,发送方调用Send命令时,接收方需要提前调用Recv命令.

发送方和接收方都需要进行两步操作:用QP来进行发送和接收数据,用CQ来通知发送或接收任务的完成.

对于CQ中产生的新消息,RDMA应用可以采用轮询的方式,定时检查CQ,也可以采用基于事件的通知方式.

RDMA的技术实现需要硬件和软件的支持.

目前,主要有3种RDMA技术,分别是InfiniBand、RoCE[21](RDMAoverConvergedEthernet)、iWARP[22](internetWideAreaRDMAProtocol).

其中,InfiniBand是一种专计算机系统应用http://www.

c-s-a.

org.

cn2020年第29卷第10期2专论综述SpecialIssue为RDMA设计的网络,而RoCE和iWARP都是基于以太网的RDMA技术,支持相应的Verbs接口.

RoCE具有和InfiniBand相同的上层协议栈,在数据链路层完全兼容以太网,而iWARP则保留了TCP/IP的完整协议栈.

3网络I/O虚拟化在虚拟化技术中,除了CPU虚拟化,内存虚拟化等,I/O虚拟化也是必不可少的组成部分.

I/O的虚拟化方法主要有:设备模拟,全虚拟化,半虚拟化和设备直连[23].

(1)设备模拟:用纯软件来模拟I/O设备,实现硬件设备所具备的接口.

软件模拟可以应用于缺乏物理设备的场景下,性能较差.

(2)全虚拟化:客户机中的I/O请求会直接陷入虚拟机监视器,并由其将请求映射到物理设备,由设备驱动完成I/O请求.

全虚拟化需要虚拟机监视器具有比主机操作系统更高的优先级,可以进行与操作系统无关的存储管理和虚拟化环境的切换.

(3)半虚拟化:使用前后端分离的驱动来处理I/O请求,前端驱动程序位于客户机操作系统,转发客户机应用的I/O请求,后端驱动程序安装在虚拟机监视器中,接收前端转发的请求并映射到对应的物理设备,由设备驱动处理请求.

半虚拟化在实现上比全虚拟化简单,在性能上比设备模拟好,但需要修改客户机操作系统.

(4)旁路直连:由于客户机和设备之间存在监视器,上述三种方法都会给I/O性能带来额外的开销.

旁路直连方法绕过了虚拟机监视器,由客户机直接使用物理设备,因此,能提高I/O性能并能开放硬件设备的所有功能.

最初,旁路直连只允许简单的设备直连,即物理设备被一台客户机独占.

之后,通过SR-IOV(Single-RootInput/OutputVirtualization)[24]等方式,设备可以提供多个接口供多台客户机直接使用.

网卡是常见的I/O设备,网络传输是典型的I/O密集型任务.

网络I/O虚拟化需要考虑虚拟化方案的性能.

常用的网络I/O虚拟化方案有硬件辅助的虚拟化方案,如SR-IOV,和软件辅助的虚拟化方案,如半虚拟化等.

4RDMA虚拟化RDMA作为一种高性能的网络传输技术,在数据中心和云计算系统中应用十分广泛.

为了维持云环境中的隔离性,可移植性等,不能像原生环境一样使用RDMA,需要进行RDMA虚拟化,这就不可避免地在RDMA的使用引入额外的开销.

如何在虚拟化RDMA的同时,尽可能地维持原生的性能,这是一大挑战.

RDMA网络传输过程与TCP/IP网络不同,传统的网络I/O虚拟化方案并不一定适用于RDMA网络虚拟化.

此外,RDMA网络的应用需求广泛,应用场景众多,各种场景下RDMA硬件软件栈也不尽相同,这也给RDMA的虚拟化带来了一定的挑战.

随着云计算的发展,RDMA的虚拟化技术也在不断发展,覆盖更多的应用场景.

针对不同的应用场景,RDMA的虚拟化方法也不同.

从虚拟化方法的实现上来讲,总体可以分为硬件辅助的虚拟化方法,如设备直连和SR-IOV[25,26];软件辅助的虚拟化方法,有半虚拟化方案vRDMA[27]和vSocket[28,29]等,混合虚拟化方案HyV[30,31]和virtio-RDMA等[32,33],针对容器的虚拟化方案FreeFlow等[34–36];纯软件模拟的方法,如SoftRoCE[37]和SoftiWARP[38]等.

4.

1硬件辅助虚拟化硬件辅助的虚拟化方法让RDMA应用直接使用物理网卡设备,而不用经过虚拟机监视器或其他虚拟机层.

主要有设备直连和SR-IOV两种方案:(1)设备直连:由虚拟机监视器将整个RDMA网卡设备透传给一个虚拟机.

如图2左侧所示,该方案只能让RDMA网卡设备被一个虚拟机(灰色部分)独占,此时虚拟机的RDMA性能和原生RDMA一致.

但是,RDMA网卡设备没法与其他虚拟机或虚拟机监视器共享,虚拟机迁移,快照等管理功能受到限制.

图2设备直连和SR-IOV(2)SR-IOV:在支持SR-IOV的RDMA网卡上,通过RDMA物理网卡PF(PhysicalFunction)拥有的多个VF(VirtualFunction),将一个RDMA物理网卡注册为多个独立的虚拟设备.

如图2右侧所示,每个VF都有自己的配置空间,可以分配给一个客户机,同时虚拟2020年第29卷第10期http://www.

c-s-a.

org.

cn计算机系统应用SpecialIssue专论综述3机监视器仍可访问物理设备并管理注册的虚拟设备.

因此,SR-IOV能让多个客户机以及虚拟机监视器共享物理RDMA网卡.

SR-IOV的性能非常接近于原生RDMA性能,但是,实现上需要硬件的支持,而且虚拟机的迁移和子网管理等功能受到限制.

Jithin等人分析了SR-IOV技术对于InfiniBand网络的影响,重点评估了MPI(MessagePassingInterface),PGAS(PartitionedGlobalAddressSpace)的性能表现,其结果发现:在点对点通信中,对于大多数长度的消息SR-IOV的性能都能与原生网络相当,但在集合通信中,SR-IOV性能比原生网络要差[25].

同样针对InfiniBand网络,Musleh等人通过对网卡中断参数进行调优,提高了SR-IOV系统的响应能力,减少了15–30%的虚拟化开销[26].

4.

2软件辅助虚拟化硬件辅助的虚拟化方案,不仅需要硬件支持,也不利于云计算环境下虚拟机的统一管理.

软件辅助的虚拟化方法更加灵活,鉴于不同的应用场景,可以进一步细分为虚拟机环境下的半虚拟化方法vRDMA、混合虚拟化方法HyV以及容器环境下的FreeFlow框架等.

4.

2.

1虚拟机环境从针对应用来看,虚拟机环境下的RDMA虚拟化方案主要有面向RDMA应用的vRDMA[27],HyV[30,31]和virtio-RDMA等[32,33],以及面向Socket应用的vSocket[28,29]等.

从虚拟化方式来看,vRDMA和vSocket等和传统半虚拟化方式相似,HyV和virtio-RDMA则采用了混合虚拟化方式,两者主要区别在于在RDMA数据路径上,混合虚拟化方式实现了零拷贝,绕过了监视器或主机内核.

VMware提出了适应于vSphere[39]的RDMA半虚拟化框架vRDMA,由分离的前后端驱动组成.

前端驱动位于客户机,向客户机应用提供虚拟的Verbs接口,并转发应用的RDMA请求给虚拟机监视器,后端位于虚拟机监视器,负责转发来自虚拟机的RDMA请求给RDMA驱动,由RDMA驱动执行请求.

在跨主机的数据传输时,数据会经过后端驱动到客户机应用.

因此,vRDMA的数据传输过程并不能完全绕过监视器,虽然向客户机隐藏了RDMA设备细节,便于虚拟机迁移和管理,但也带来了一定的延迟.

此外,当使用基于事件的完成通知时,主机和客户机都进行轮询操作,增加了CPU负载.

HyV的整体框架如图3所示,将虚拟机中RDMA的控制路径和数据路径进行了分离.

针对控制路径,HyV采用了半虚拟化技术,其前端驱动负责截获应用的RDMA请求并转发给监视器的后端驱动,后端驱动则会继续转发RDMA请求给主机的RDMA网卡驱动.

此外,后端驱动还会将主机的RDMA资源(例如QP,CQ等)映射到虚拟机中RDMA应用的地址空间中.

同样的,RDMA应用的内存缓冲区也可以通过前后端驱动映射到主机的内存空间.

与传统半虚拟化不同的是,在完成内存映射后,数据传输可以直接在虚拟机中RDMA应用的数据路径上进行,从而绕过监视器,减少数据传输的延迟.

图3HyV框架在具体实现上,HyV基于KVM[40]虚拟机.

在控制路径上,RDMA利用了半虚拟化I/O框架virtio[41],虚拟机使用定制的内核驱动转发控制命令,主机端使用vhost[42]后端驱动.

在数据路径上,当RDMA应用采用基于事件的通知机制时,采用加锁共享环形队列的方式,以减少通知的延迟.

由于HyV在具体实现上均需要定制的虚拟机和主机内核驱动,因此对RDMA驱动依赖较强,容器受限于具体的内核版本和网卡硬件.

vRDMA只适应于vSphere,而HyV则受限于具体版本的Linux系统.

为了支持HPC环境轻量级系统OSv的RDMA虚拟化,Fan等人提出了与HyV相似的轻量级框架virtio-RDMA.

客户机应用的RDMA请求直接从用户空间转发到主机,避免客户机中用户态到内核态的上下文切换,同时减少了对RDMA内核驱动模块的依赖.

此外,主机后端驱动还可以使用vhost-user[43].

该驱动位于用户空间,减少了用户和内核之间的切换次数.

对于同一主机的客户机通信,该框架采用共计算机系统应用http://www.

c-s-a.

org.

cn2020年第29卷第10期4专论综述SpecialIssue享内存的方式进行.

类似virtio-RDMA的还有Mouzakitis等人提出的轻量级的RDMA虚拟化框架[33],同样利用用户级别的API,避免对内核驱动的依赖.

不同的是,在控制路径上,主机和客户机之间采用共享内存方式来交互.

除了针对RDMA应用的虚拟化方案,王冬洋等人提出了针对socket应用的RDMA虚拟化框架vSocket,利用RDMA网络的高性能加速虚拟机之间的socket通信.

vSocket同样由前后端驱动组成,前端驱动中的用户库负责拦截Socket应用的API请求.

vSokcet针对socket通信中连接建立和数据传输做不同处理,为了保障安全性,连接建立过程通过重用原有的内核协议栈进行.

与HyV不同的是,当连接建立后,vSocket通过前后端驱动的半虚拟化框架进行数据传输,因为云环境中的网络往往需要主机对来自客户机的数据包进行封装或者对送往客户机的数据包进行解封,而RDMA网卡又不支持该功能,例如VXLAN等.

此外,vSokcet后端驱动直接面向主机Verbs接口,即数据再通过主机Verbs库进行传输,因此,vSocket具有一定的通用性,不像HyV依赖特定内核版本,维护困难等.

4.

2.

2容器环境随着容器技术的发展和流行,许多RDMA应用部署在轻量级的容器中.

针对虚拟机环境的RDMA虚拟化方案,如vRDMA和HyV等,并不适应于容器环境.

针对容器环境的RDMA虚拟化框架有FreeFlow等[34–36].

FreeFlow[34]在设计上和HyV十分类似,对RDMA的控制路径和数据路径分开处理.

FreeFlow在RDMA应用容器和底层RDMA驱动之间设计了一个路由层,该层由容器实现,负责接收来自RDMA应用容器的控制命令,并进行RDMA网络传输,实现对RDMA传输的管理和控制.

路由容器和RDMA应用容器之间通过共享内存实现RDMA传输数据的零拷贝.

如图4所示,FreeFlow的架构由3部分组成(图中灰色部分),分别是位于RDMA应用容器的网络库,路由容器,和网络编排器组成.

网络库负责为容器中的RDMA应用提供虚拟的与原生一致的Verbs接口.

在控制路径上,应用容器中的FreeFlow网络库通过套接字或共享内存的进程间通信方式转发命令和参数给路由容器.

每个主机上都有一个路由容器,和RDMA应用容器位于同一虚拟网络,路由容器可以直接访问RDMA网卡设备,并执行接收到的RDMA应用请求.

路由容器通过共享内存的方式获取RDMA应用数据并将网卡接收数据返回给RDMA应用,在数据路径上做到了零拷贝.

网络编排器负责容器IP的统一管理以及对RDMA网络传输的数据策略,例如QoS(QualityofService)或计费服务等.

图4FreeFlow框架FreeFlow适应于容器云计算环境,强调了对RDMA网络传输数据路径的控制,提供了数据的QoS和流量计费等策略.

但是,FreeFlow在虚拟化过程中,在RDMA的控制路径上带来了额外的开销,采用自旋轮询共享内存的方式需要占用CPU资源,而采用Socket通信会造成更高的延迟;在数据路径上,应用容器和路由容器通过共享内存实现零拷贝,也带来了一定的安全问题.

除了FreeFlow,Mellanox针对Linux命名空间和控制组机制,让多个容器可以共享同一个RDMA物理网卡[35,36].

该方案将物理RDMA网卡通过MACVLAN技术扩展为多个虚拟接口,每个容器可以使用一个或多个虚拟接口.

同时,对于QP,CQ等网卡资源采用更细粒度的控制组机制,容器可以直接使用硬件资源进行数据传输.

该方案虽然保障了隔离性,但是使用VLAN网络时,在容器迁移过程中需要更新路由信息,因此可移植性比较差.

另外,由于容器直接使用RDMA网卡进行数据传输,其控制性比FreeFlow要差.

4.

3纯软件模拟RDMA网络的普及程度比不上普通以太网.

在缺乏RDMA硬件的环境中,可以通过软件模拟的方法来实现RDMA通信.

在该方法中,RDMA设备的功能完全通过软件的方式得以实现,并向用户提供与原生一致的Verbs编程接口.

因此,无需依赖RDMA网卡、交换机等硬件设备.

RDMA软件模拟方案主要有SoftRocE[37]和Softi-WARP[38].

SoftRocE是一个软件辅助实现的RoCE-2020年第29卷第10期http://www.

c-s-a.

org.

cn计算机系统应用SpecialIssue专论综述5Linux驱动程序,用于在普通以太网上模拟RoCE网络.

而SoftiWARP是用于在以太网络上模拟iWARP网络的驱动程序.

在具体实现上,SoftRocE和SoftiWARP都可以分为用户层和内核层两个部分.

用户层用以支持上层RDMA应用,用户级库提供了与Verbs一致的接口.

内核层包含了可加载的内核模块,用以支持内核层次的应用.

SoftRoCE的内核模块利用UDP栈进行数据传输,而SoftiWARP则在TCP内核套接字之上运行.

SoftRoCE和SoftiWARP可以让缺乏RDMA硬件条件的大数据中心或云计算平台构建起可用的RDMA网络.

但是,由于软件模拟的方法基于TCP/UDP进行网络通信,它们的性能上受到限制,在吞吐量和延迟上和传统的以太网TCP/UDP通信较为接近,和原生RDMA网络通信的性能差距较大.

此外,SoftRoCE或SoftiWARP由于包含内核模块,也受限于特定版本的Linux系统.

因此,SoftRoCE和SoftiWARP主要用于测试、应用开发以及缺乏RDMA硬件却需要部署RDMA应用的环境.

4.

4评价目前,RDMA的虚拟化方案主要可以分为硬件辅助和软件辅助的方案.

虚拟机环境下,软件辅助的虚拟化方案可以细分为半虚拟化(例如vRDMA和vSocket)和混合虚拟化(例如HyV和virtio-rdma等),两者主要区别在于RDMA数据路径是否绕过主机监视器或内核.

容器环境下,主要有FreeFlow等虚拟化框架.

此外,在缺少RDMA硬件条件的场景下,可以用SoftiWARP或SoftRoCE来模拟RDMA网络.

RDMA虚拟化的目标是既保证网络的高性能,同时也不损失云环境的特点.

因此,对于上述方案的虚拟化效果,我们从RDMA网络性能与云环境特点这两个方面进行讨论.

针对RDMA网络性能,主要考虑延迟,吞吐量和CPU负载这3个指标.

针对云环境,则从隔离性,可移植性,控制性3个维度来讨论.

其中:(1)隔离性:每个虚拟机或容器实例都有其专属的RDMA网络资源,不与其他实例冲突.

(2)可移植性:虚拟机或容器实例迁移管理的便捷程度.

例如,虚拟机的快照和迁移,容器的迁移等.

(3)控制性:RDMA虚拟化方案对于RDMA网络传输的控制,例如流量限制,流量计费和QoS等.

针对RDMA网络性能,硬件辅助的虚拟化方案由于没有软件虚拟层的额外开销,所以延迟和吞吐量可以与原生RDMA相当.

但是SR-IOV需要更多的CPU负载来处理网卡中断以保证网络性能.

软件辅助虚拟化一般将控制路径和数据路径分别处理.

在数据路径上,像HyV,virtio-RDMA和FreeFlow等框架通过内存映射或共享内存实现了零拷贝,因此,延迟和吞吐量较好,像传统半虚拟化方案的vRDMA和vSocket等,其数据需要经过监视器或主机内核,因而延迟较高.

在控制路径上,通过共享内存的方式交互延迟更低,但依赖CPU轮询,通过套接字等转发的方式则可以减少CPU负载,但延迟更高.

针对云环境特点,硬件辅助的虚拟化方案往往难以达到所有的维度,例如,容器与SR-IOV网卡VF设备的IP绑定而不能灵活迁移.

软件辅助的虚拟化方案中,混合虚拟化HyV等没有对数据路径进行统一控制,因而难以实现云环境下的网络限速,QoS等数据策略,FreeFlow则通过对数据路径的控制改进了这些不足.

纯软件模拟的方式,由于没有硬件限制,容易具备云环境下的各个特点.

由于RDMA技术的多样性以及RDMA虚拟化应用场景和实现平台的差异性,本文选择定性分析,分别从上述七个维度对不同虚拟化方案进行评估,其中每个维度定性地分为差,较差,较好,好四个级别,以尽可能体现出不同方案在各个维度上的差异.

各RDAM虚拟化方案的评估结果如表1所示.

表1RDMA虚拟化方案评估表方案代表传输延迟吞吐量CPU负载隔离性可移植性控制性设备直连—低高低好差差SR-IOV—较低较高较低好较差差软件模拟SoftRoCE,SoftiWARP高低高好好好半虚拟化vRDMA,vSocket较高较低较高较好好好混合虚拟化HyV,virtio-RDMA较低较高较低较好较好较差容器环境FreeFlow较低较高较高较好好好5展望目前,针对不同的云计算环境,有不同的RDMA虚拟化解决方案.

例如,针对虚拟机环境的vRDMA和HyV、针对容器环境的FreeFlow、针对普通以太网环境的SoftiWARP和SoftRoCE以及基于硬件的SR-IOV虚拟化等.

我们对以后的RDMA虚拟化技术研究做出了以下展望:计算机系统应用http://www.

c-s-a.

org.

cn2020年第29卷第10期6专论综述SpecialIssue(1)通用性:通用性包含针对不同RDMA网络的通用性以及针对不同云计算环境的通用性.

目前,最新的RDMA网络虚拟化方案都考虑到了对不同RDMA网络的通用性,例如HyV和FreeFlow都支持3种不同的RDMA网络.

但是,对于不同云计算环境,例如不同虚拟方式(容器或虚拟机),不同的操作系统等,还没有通用的RDMA解决方案.

通用的RDMA虚拟化方案,有利于统一部署,对RDMA应用统一管理,能适用于复杂的云计算环境.

(2)安全性:RDMA原生的通信模式和流程是安全的,但是不同的虚拟化方案可能会引入不同程度的通信安全问题.

通过软件辅助的RDMA虚拟化网络,如FreeFlow,HyV等,在转发控制命令的过程中可能被恶意劫持;通过硬件辅助的方案和纯软件模拟方案在通信方式上与原生RDMA没有区别.

因此,可以尝试通过额外的安全流程来弥补虚拟化中的安全漏洞,保证RDMA通信安全.

(3)编排管理:无论是使用RDMA应用的虚拟机,还是容器,在云计算环境中都需要管理或编排.

编排管理的目的:通过管理调度来高效利用集群的RDMA网卡资源,提高整个集群的运行效率,实现负载均衡等.

RDMA网卡作为重要的网络资源,在如Kubernetes之类的容器编排工具里面如何调度管理,这是一个值得不断研究优化的方向.

而在虚拟机环境中,直接使用SR-IOV技术会导致主机无法对虚拟机使用的RDMA资源进行统一管理,即便在使用类似HyV的软件辅助的虚拟化方法时,虚拟机无法完全感知主机RDMA资源,因此也需要思考如何对主机的RDMA资源进行高效动态的分配.

(4)嵌套虚拟环境:在实际应用中,许多RDMA应用容器并非部署于裸机,而是分布于虚拟机中.

此外,还有虚拟机的嵌套.

在这些复杂的嵌套虚拟环境下,如何使RDMA虚拟化,让最内层的虚拟环境同样能够利用到RDMA网络的高性能,也是需要考虑的问题.

(5)智能网卡:智能网卡或FPGA应用越来越广泛,已有一些研究将其应用到RDMA网络虚拟化[33],协助CPU处理网络负载.

与传统网卡相比,智能网卡可以处理更加复杂的网络负载并支持可替换的数据平面.

在RDMA虚拟化方案中,也可以思考如何与智能网卡的可编程功能高效结合,以提高云环境下的RDMA网络性能.

参考文献WangZG,LiuR,ChenYF,etal.

COREMU:Ascalableandportableparallelfull-systememulator.

Proceedingsofthe16thACMSymposiumonPrinciplesandPracticeofParallelProgramming.

SanAntonio,TX,USA.

2011.

213–222.

[doi:10.

1145/2038037.

1941583]1SongCH,WangWW,YewPC,etal.

Unleashingthepoweroflearning:Anenhancedlearning-basedapproachfordynamicbinarytranslation.

Proceedingsofthe2019USENIXAnnualTechnicalConference.

Renton,WA,USA.

2019.

77–89.

2FangZM,MinQH,ZhouKY,etal.

Transformer:Afunctional-drivencycle-accuratemulticoresimulator.

ProceedingsofDACDesignAutomationConference2012.

SanFrancisco,CA,USA.

2012.

106–114.

[doi:10.

1145/2228360.

2228381]3ZhangWH,JiXF,LuYP,etal.

Prophet:Aparallelinstruc-tion-orientedmany-coresimulator.

IEEETransactionsonParallelandDistributedSystems,2017,28(10):2939–2952.

[doi:10.

1109/TPDS.

2017.

2700307]4WangHJ,MinQH,LiY,etal.

RPSim:Arapidprototypingfull-systemsimulatorforSoCsoftwaredevelopment.

20149thIEEEInternationalConferenceonNetworking,Architecture,andStorage.

Tianjin,China.

2014.

259–267.

[doi:10.

1109/NAS.

2014.

45]5ZhangWH,WangHJ,LuYP,etal.

Aloosely-coupledfull-systemmulticoresimulationframework.

IEEETransactionsonParallelandDistributedSystems,2016,27(6):1566–1578.

[doi:10.

1109/TPDS.

2015.

2455499]6Docker.

https://www.

docker.

com/,2020.

[2020-04-18].

7rKt,asecurity-minded,standards-basedcontainerengine.

https://coreos.

com/rkt/,2020.

[2020-04-18].

8AbadiM,BarhamP,ChenJM,etal.

TensorFlow:Asystemforlarge-scalemachinelearning.

Proceedingsofthe12thUSENIXSymposiumonOperatingSystemsDesignandIm-plementation.

Berkeley,CA,USA.

2016.

265–283.

9RDMA-basedapachespark.

http://hibd.

cse.

ohio-state.

edu/,2020.

[2020-04-18].

10RDMA-basedapachehadoop.

http://hibd.

cse.

ohio-state.

edu/,2020.

[2020-04-18].

11PaddlePaddle.

https://github.

com/PaddlePaddle/Paddle.

[2020-03-09].

12Top500.

https://www.

top500.

org/statistics/list/.

[2020-03-09].

13IntroductiontoInfiniBandTM.

https://www.

mellanox.

com/pdf/whitepapers/IB_Intro_WP_190.

pdf,2010.

[2020-04-18].

14陈游旻,陆游游,罗圣美,等.

基于RDMA的分布式存储系统研究综述.

计算机研究与发展,2019,56(2):227–239.

152020年第29卷第10期http://www.

c-s-a.

org.

cn计算机系统应用SpecialIssue专论综述7[doi:10.

7544/issn1000-1239.

2019.

20170849]MitchellC,GengYF,LiJY.

Usingone-sidedRDMAreadstobuildafast,CPU-Efficientkey-valuestore.

Proceedingsofthe2013USENIXAnnualTechnicalConference.

SanJose,CA,USA.

2013.

103–114.

16LuYY,ShuJW,ChenYM,etal.

Octopus:AnRDMA-enableddistributedpersistentmemoryfilesystem.

Proceedingsofthe2017USENIXConferenceonAnnualTechnicalConference.

SantaClara,CA,USA.

2017.

773–785.

17WeiXD,ShiJX,ChenYZ,etal.

Fastin-memorytransactionprocessingusingRDMAandHTM.

Proceedingsofthe25thSymposiumonOperatingSystemsPrinciples.

Monterey,Canada.

2015.

87–104.

18DragojeviD,NarayananM,HodsonO,etal.

FaRM:Fastremotememory.

Proceedingsofthe11thUSENIXSympo-siumonNetworkedSystemsDesignandImplementation.

Berkeley,CA,USA.

2014.

401–414.

19Verbslibrary:Libibverbs.

https://www.

openfabrics.

org/downloads/libibverbs/,2011.

[2020-04-18].

20RoCEIntroduction.

http://www.

roceinitiative.

org/roce-intro-duction/,2020.

[2020-04-18].

21iWARP*RDMAhereandnow.

https://www.

intel.

com/content/dam/www/public/us/en/documents/technology-briefs/iwarp-rdma-here-and-now-technology-brief.

pdf,2019.

[2020-04-18].

22ZhangBB,WangXL,LaiRF,etal.

AsurveyonI/Ovirtual-izationandoptimization.

ProceedingsoftheFifthAnnualChinaGridConference.

Guangzhou,China.

2010.

117–123.

[doi:10.

1109/ChinaGrid.

2010.

54]23SinglerootI/Ovirtualization.

http://pcisig.

com/specifications/iov/single_root/,2020.

[2020-04-18].

24JoseJ,LiMZ,LuXY,etal.

SR-IOVsupportforvirtualiza-tiononinfinibandclusters:Earlyexperience.

Proceedingsofthe13thIEEE/ACMInternationalSymposiumonCluster,Cloud,andGridComputing.

Delft,theNetherlands.

2013.

385–392.

[doi:10.

1109/CCGrid.

2013.

76]25MuslehM,PaiV,WaltersJP,etal.

BridgingthevirtualizationperformancegapforHPCusingSR-IOVforInfiniBand.

Proceedingsofthe2014IEEEInternationalConferenceonCloudComputing.

Anchorage,AK,USA.

2014.

627–635.

[doi:10.

1109/CLOUD.

2014.

89]26TowardaparavirtualvRDMAdeviceforVMwareESXiguests.

http://download3.

vmware.

com/software/vmw-tools/papers/VMTJ_issue_2.

pdf,2020.

[2020-04-18].

27WangDY,FuBZ,LuG,etal.

vSocket:VirtualsocketinterfaceforRDMAinpublicclouds.

Proceedingsofthe15thACMSIGPLAN/SIGOPSInternationalConferenceon28VirtualExecutionEnvironments.

Providence,RI,USA.

2019.

179–192.

[doi:10.

1145/3313808.

3313813]王冬洋.

公有云中高性能网络系统研究[博士学位论文].

合肥:中国科学技术大学,2019.

29PfefferleJ,StuediP,TrivediA,etal.

AhybridI/Ovirtualiza-tionframeworkforRDMA-capablenetworkinterfaces.

Proceedingsofthe11thACMSIGPLAN/SIGOPSInterna-tionalConferenceonVirtualExecutionEnvironments.

Is-tanbul,Turkey.

2015.

17–30.

[doi:10.

1145/2731186.

2731200]30PfefferleJ.

vVerbs:AparavirtualsubsystemforRDMA-capablenetworkinterfaces[Master'sthesis].

Zurich,Switzer-land:ETHZurich,2014.

31TowardsaLightweightRDMAPara-VirtualizationforHPC.

https://mediatum.

ub.

tum.

de/doc/1344417/1344417.

pdf,2020.

[2020-04-18]32MouzakitisA,PintoC,NikolaevN,etal.

LightweightandgenericRDMAenginepara-virtualizationfortheKVMhy-pervisor.

Proceedingsof2017InternationalConferenceonHighPerformanceComputing&Simulation.

Genoa,Italy.

2017.

737–744.

[doi:10.

1109/HPCS.

2017.

112]33KimD,YuTL,LiuHH,etal.

FreeFlow:Software-basedvirtualRDMAnetworkingforcontainerizedclouds.

Pro-ceedingsofthe16thUSENIXConferenceonNetworkedSystemsDesignandImplementation.

Boston,MA,USA.

2019.

113–126.

34ContainingRDMAandhighperformancecomputing.

http://caxapa.

ru/thumbs/808632/containing_rdma_final.

pdf,2020.

[2020-04-18].

35RDMAcontainersupport.

https://downloads.

openfabrics.

org/Media/Monterey_2015/Tuesday/tuesday_08.

pdf,2020.

[2020-04-18].

36SoftRoCE:SoftwareRDMAoverConvergedEthernet.

https://github.

com/SoftRoCE,2017.

[2020-04-18].

37Softiwarp.

https://www.

openfabrics.

org/downloads/Media/Sonoma2009/Sonoma_2009_Mon_softiwrp.

pdf,2020.

[2020-04-18].

38VMwarevSphere.

https://www.

vmware.

com/products/vsphere.

html,2020.

[2020-04-18].

39KVM.

http://www.

linux-kvm.

org/index.

phptitle=Main_Page&oldid173792.

(2016-11-07)[2020-03-09].

40Virtio.

http://www.

linux-kvm.

org/index.

phptitle=Virtio&oldid173787.

(2016-10-12)[2020-03-09].

41UsingVhost.

http://www.

linux-kvm.

org/index.

phptitle=UsingVhost&oldid3513.

(2011-03-08)[2020-04-18].

42Vhost-user.

https://wiki.

qemu.

org/Features/VirtioVhostUser.

(2018-02-06)[2020-04-18].

43计算机系统应用http://www.

c-s-a.

org.

cn2020年第29卷第10期8专论综述SpecialIssue

edu.

cn摘要:RDMA网络具有高带宽,低延时,低CPU负载的特点,广泛应用于数据密集型任务中,例如深度学习,高性能计算,数据分析等.

RDMA的实现需要软硬件支持,在云环境下,RDMA虚拟化方案有助于多用户共享RDMA网络传输的高性能,同时实现对RDMA网络的统一管理和控制.

本文调研了近年来的RDMA虚拟化解决方案,覆盖了虚拟机和容器环境;然后将这些解决方案进行分类和比较;最后,对RDMA虚拟化中存在的问题和未来的发展做出了总结和展望.

关键词:RDMA;虚拟化;云计算引用格式:代超,刘强,蒋金虎,张为华.

RDMA虚拟化相关技术研究.

计算机系统应用,2020,29(10):1–8.

http://www.

c-s-a.

org.

cn/1003-3254/7637.

htmlSurveyonRDMAVirtualizationTechnologyDAIChao1,LIUQiang1,JIANGJin-Hu2,ZHANGWei-Hua21(SoftwareSchool,FudanUniversity,Shanghai201203,China)2(ShanghaiKeyLaboratoryofDataScience,FudanUniversity,Shanghai201203,China)Abstract:RDMAnetworkshavethecharacteristicsofhighbandwidth,lowlatency,andlowCPUload,andareusedinawiderangeofdata-intensivetasks,suchasdeeplearning,high-performancecomputing,anddataanalysis.

Theimple-mentationofRDMArequiressoftwareandhardwaresupport.

Inacloudenvironment,theRDMAvirtualizationsolutionshelpmultipleuserstosharethehighperformanceofRDMAnetwork,whileachievingunifiedmanagementofRDMAnetworks.

Inthisstudy,solutionsofRDMAvirtualizationinrecentyearsarecollected,whichcovervirtualma-chinesandcontainerenvironments.

Then,thesesolutionsareclassifiedandcompared.

Finally,theexistingproblemsandfuturedevelopmentinRDMAvirtualizationareanalyzed.

Keywords:RDMA;virtualization;cloudcomputing1引言随着互联网技术的快速发展,应用的用户规模越来越大,需要的服务器资源越来越多.

传统服务器部署和维护成本高,资源利用率低,难以跟上互联网应用的发展需求.

为了实现对服务器资源的高效利用,满足大规模用户的需求,亚马逊最早于2006年推出了弹性云计算服务.

云计算将服务器硬件资源,例如CPU,内存,网络等进行虚拟化,以按需使用的方式提供给多用户使用.

目前,云计算已经引起了学界和业界的高度重视,例如,谷歌、微软、阿里巴巴和腾讯等企业也竞相发布了各种云计算平台.

虚拟化技术广泛应用于云计算,模拟器,安全,分析等领域[1–6].

虚拟机相关的虚拟化技术包括CPU虚拟化,内存虚拟化,I/O虚拟化等.

虚拟化技术可以分为硬计算机系统应用ISSN1003-3254,CODENCSAOBNE-mail:csa@iscas.

ac.

cnComputerSystems&Applications,2020,29(10):18[doi:10.

15888/j.

cnki.

csa.

007637]http://www.

c-s-a.

org.

cn中国科学院软件研究所版权所有.

Tel:+86-10-62661041①基金项目:国家自然科学基金(61672160)Foundationitem:NationalNaturalScienceFoundationofChina(61672160)收稿时间:2020-03-10;修改时间:2020-04-10;采用时间:2020-04-21;csa在线出版时间:2020-09-30SpecialIssue专论综述1件辅助的虚拟化和软件辅助的虚拟化等.

容器也是目前流行的虚拟化方案.

区别于虚拟机,容器通过Linux的命名空间和控制组机制,让应用程序在独立的运行时环境执行,具有轻量级隔离和可移植的特点.

目前,流行的容器引擎有Docker[7],RKT[8]等.

RDMA(RemoteDirectMemoryAccess)是一种高速网络传输技术,传输数据时可以绕过操作系统直接对远端内存进行读写.

相较于传统的TCP/IP网络,RDMA具有低延迟,高吞吐,低CPU负载的特点,更适合数据中心的网络传输需求.

目前,RDMA广泛应用于云计算系统和大数据平台的网络密集型任务,例如TensorFlow[9]、Spark[10]、Hadoop[11]等.

RDMA技术提供了高性能的网络传输,虚拟机和容器技术提供了云计算用户隔离,共享物理资源以及灵活管理的特点.

RDMA虚拟化技术的目标就是将云环境的特点与RDMA网络的高性能特点相结合,以满足云计算用户对可靠的高性能RDMA网络传输服务的需求.

本文调研了近年来RDMA虚拟化的主要解决方案,覆盖了虚拟机和容器的云计算环境,对相关技术进行了系统全面的分析和讨论.

在此基础上,对现有RDMA虚拟化技术进行了总结,对存在的问题进行了探讨和展望.

2RDMA介绍RDMA是一种远程直接访问内存的网络技术.

RDMA的出现是为了解决数据中心网络传输的延迟问题.

在使用RDMA连接时,主机可以直接绕过双方的操作系统,对远端主机的内存进行读写,从而避免经过内核时数据拷贝的开销,同时不占用CPU资源.

因此,相较于传统的TCP/IP网络,RDMA具有低延迟,高吞吐,低CPU负载的特点,更适合数据中心的网络传输需求.

目前,RDMA广泛应用于人工智能、高性能计算、大数据分析和分布式存储等领域.

TensorFlow、PaddlePaddle[12]等流行深度学习框架均支持RDMA;根据2019年11月份的HPCtop500统计[13],排名前10的超算系统有6个使用了200Gb/sInfiniBand[14](一种RDMA网络),500强名单中使用该网络的超算系统达到了140个;大数据分析框架Spark、Hadoop等均有用到RDMA的成熟方案;在分布式存储系统领域,键值对系统、文件系统、分布式事务等也都利用了RDMA网络特性[15],例如键值对系统Pilaf[16]、文件系统Octopus[17]以及分布式事务系统DrTM[18]、FaRM[19]等.

如图1所示,应用通过调用统一的Verbs[20]接口来进行RDMA网络传输.

完整的RDMA传输过程具有控制路径和数据路径.

首先,在控制路径上建立连接,两端的RDMA应用在各自的网卡上创建QP(QueuePairs)和CQ(CompleteQueue),并完成内存注册.

QP和CQ均映射到应用的地址空间,其中,QP由接收队列和发送队列组成,应用通过它们控制RDMA传输,而CQ负责提供任务完成的通知.

然后,两端应用的QP通过交换信息来完成配对.

当连接建立后,在数据路径上,应用可以绕过内核,直接通过QP请求网卡将内存数据以DMA(DirectMemoryAccess)方式读取到网卡缓冲并发送给远端,或者将网卡缓冲中接收的远端数据以DMA方式写入本地内存.

图1RDMA通信RDMA有Write/Read和Send/Recv两种通信方式.

Write/Read是单边操作,读(写)方不需要事先通知对方,在建立连接后直接读(写)远端服务中RDMA应用内存地址中的数据.

例如,在建立RDMA连接后,应用调用Write命令,根据远端提供的虚拟机地址,直接通过RDMA网卡进行数据传输.

Send/Recv是双边操作,发送方调用Send命令时,接收方需要提前调用Recv命令.

发送方和接收方都需要进行两步操作:用QP来进行发送和接收数据,用CQ来通知发送或接收任务的完成.

对于CQ中产生的新消息,RDMA应用可以采用轮询的方式,定时检查CQ,也可以采用基于事件的通知方式.

RDMA的技术实现需要硬件和软件的支持.

目前,主要有3种RDMA技术,分别是InfiniBand、RoCE[21](RDMAoverConvergedEthernet)、iWARP[22](internetWideAreaRDMAProtocol).

其中,InfiniBand是一种专计算机系统应用http://www.

c-s-a.

org.

cn2020年第29卷第10期2专论综述SpecialIssue为RDMA设计的网络,而RoCE和iWARP都是基于以太网的RDMA技术,支持相应的Verbs接口.

RoCE具有和InfiniBand相同的上层协议栈,在数据链路层完全兼容以太网,而iWARP则保留了TCP/IP的完整协议栈.

3网络I/O虚拟化在虚拟化技术中,除了CPU虚拟化,内存虚拟化等,I/O虚拟化也是必不可少的组成部分.

I/O的虚拟化方法主要有:设备模拟,全虚拟化,半虚拟化和设备直连[23].

(1)设备模拟:用纯软件来模拟I/O设备,实现硬件设备所具备的接口.

软件模拟可以应用于缺乏物理设备的场景下,性能较差.

(2)全虚拟化:客户机中的I/O请求会直接陷入虚拟机监视器,并由其将请求映射到物理设备,由设备驱动完成I/O请求.

全虚拟化需要虚拟机监视器具有比主机操作系统更高的优先级,可以进行与操作系统无关的存储管理和虚拟化环境的切换.

(3)半虚拟化:使用前后端分离的驱动来处理I/O请求,前端驱动程序位于客户机操作系统,转发客户机应用的I/O请求,后端驱动程序安装在虚拟机监视器中,接收前端转发的请求并映射到对应的物理设备,由设备驱动处理请求.

半虚拟化在实现上比全虚拟化简单,在性能上比设备模拟好,但需要修改客户机操作系统.

(4)旁路直连:由于客户机和设备之间存在监视器,上述三种方法都会给I/O性能带来额外的开销.

旁路直连方法绕过了虚拟机监视器,由客户机直接使用物理设备,因此,能提高I/O性能并能开放硬件设备的所有功能.

最初,旁路直连只允许简单的设备直连,即物理设备被一台客户机独占.

之后,通过SR-IOV(Single-RootInput/OutputVirtualization)[24]等方式,设备可以提供多个接口供多台客户机直接使用.

网卡是常见的I/O设备,网络传输是典型的I/O密集型任务.

网络I/O虚拟化需要考虑虚拟化方案的性能.

常用的网络I/O虚拟化方案有硬件辅助的虚拟化方案,如SR-IOV,和软件辅助的虚拟化方案,如半虚拟化等.

4RDMA虚拟化RDMA作为一种高性能的网络传输技术,在数据中心和云计算系统中应用十分广泛.

为了维持云环境中的隔离性,可移植性等,不能像原生环境一样使用RDMA,需要进行RDMA虚拟化,这就不可避免地在RDMA的使用引入额外的开销.

如何在虚拟化RDMA的同时,尽可能地维持原生的性能,这是一大挑战.

RDMA网络传输过程与TCP/IP网络不同,传统的网络I/O虚拟化方案并不一定适用于RDMA网络虚拟化.

此外,RDMA网络的应用需求广泛,应用场景众多,各种场景下RDMA硬件软件栈也不尽相同,这也给RDMA的虚拟化带来了一定的挑战.

随着云计算的发展,RDMA的虚拟化技术也在不断发展,覆盖更多的应用场景.

针对不同的应用场景,RDMA的虚拟化方法也不同.

从虚拟化方法的实现上来讲,总体可以分为硬件辅助的虚拟化方法,如设备直连和SR-IOV[25,26];软件辅助的虚拟化方法,有半虚拟化方案vRDMA[27]和vSocket[28,29]等,混合虚拟化方案HyV[30,31]和virtio-RDMA等[32,33],针对容器的虚拟化方案FreeFlow等[34–36];纯软件模拟的方法,如SoftRoCE[37]和SoftiWARP[38]等.

4.

1硬件辅助虚拟化硬件辅助的虚拟化方法让RDMA应用直接使用物理网卡设备,而不用经过虚拟机监视器或其他虚拟机层.

主要有设备直连和SR-IOV两种方案:(1)设备直连:由虚拟机监视器将整个RDMA网卡设备透传给一个虚拟机.

如图2左侧所示,该方案只能让RDMA网卡设备被一个虚拟机(灰色部分)独占,此时虚拟机的RDMA性能和原生RDMA一致.

但是,RDMA网卡设备没法与其他虚拟机或虚拟机监视器共享,虚拟机迁移,快照等管理功能受到限制.

图2设备直连和SR-IOV(2)SR-IOV:在支持SR-IOV的RDMA网卡上,通过RDMA物理网卡PF(PhysicalFunction)拥有的多个VF(VirtualFunction),将一个RDMA物理网卡注册为多个独立的虚拟设备.

如图2右侧所示,每个VF都有自己的配置空间,可以分配给一个客户机,同时虚拟2020年第29卷第10期http://www.

c-s-a.

org.

cn计算机系统应用SpecialIssue专论综述3机监视器仍可访问物理设备并管理注册的虚拟设备.

因此,SR-IOV能让多个客户机以及虚拟机监视器共享物理RDMA网卡.

SR-IOV的性能非常接近于原生RDMA性能,但是,实现上需要硬件的支持,而且虚拟机的迁移和子网管理等功能受到限制.

Jithin等人分析了SR-IOV技术对于InfiniBand网络的影响,重点评估了MPI(MessagePassingInterface),PGAS(PartitionedGlobalAddressSpace)的性能表现,其结果发现:在点对点通信中,对于大多数长度的消息SR-IOV的性能都能与原生网络相当,但在集合通信中,SR-IOV性能比原生网络要差[25].

同样针对InfiniBand网络,Musleh等人通过对网卡中断参数进行调优,提高了SR-IOV系统的响应能力,减少了15–30%的虚拟化开销[26].

4.

2软件辅助虚拟化硬件辅助的虚拟化方案,不仅需要硬件支持,也不利于云计算环境下虚拟机的统一管理.

软件辅助的虚拟化方法更加灵活,鉴于不同的应用场景,可以进一步细分为虚拟机环境下的半虚拟化方法vRDMA、混合虚拟化方法HyV以及容器环境下的FreeFlow框架等.

4.

2.

1虚拟机环境从针对应用来看,虚拟机环境下的RDMA虚拟化方案主要有面向RDMA应用的vRDMA[27],HyV[30,31]和virtio-RDMA等[32,33],以及面向Socket应用的vSocket[28,29]等.

从虚拟化方式来看,vRDMA和vSocket等和传统半虚拟化方式相似,HyV和virtio-RDMA则采用了混合虚拟化方式,两者主要区别在于在RDMA数据路径上,混合虚拟化方式实现了零拷贝,绕过了监视器或主机内核.

VMware提出了适应于vSphere[39]的RDMA半虚拟化框架vRDMA,由分离的前后端驱动组成.

前端驱动位于客户机,向客户机应用提供虚拟的Verbs接口,并转发应用的RDMA请求给虚拟机监视器,后端位于虚拟机监视器,负责转发来自虚拟机的RDMA请求给RDMA驱动,由RDMA驱动执行请求.

在跨主机的数据传输时,数据会经过后端驱动到客户机应用.

因此,vRDMA的数据传输过程并不能完全绕过监视器,虽然向客户机隐藏了RDMA设备细节,便于虚拟机迁移和管理,但也带来了一定的延迟.

此外,当使用基于事件的完成通知时,主机和客户机都进行轮询操作,增加了CPU负载.

HyV的整体框架如图3所示,将虚拟机中RDMA的控制路径和数据路径进行了分离.

针对控制路径,HyV采用了半虚拟化技术,其前端驱动负责截获应用的RDMA请求并转发给监视器的后端驱动,后端驱动则会继续转发RDMA请求给主机的RDMA网卡驱动.

此外,后端驱动还会将主机的RDMA资源(例如QP,CQ等)映射到虚拟机中RDMA应用的地址空间中.

同样的,RDMA应用的内存缓冲区也可以通过前后端驱动映射到主机的内存空间.

与传统半虚拟化不同的是,在完成内存映射后,数据传输可以直接在虚拟机中RDMA应用的数据路径上进行,从而绕过监视器,减少数据传输的延迟.

图3HyV框架在具体实现上,HyV基于KVM[40]虚拟机.

在控制路径上,RDMA利用了半虚拟化I/O框架virtio[41],虚拟机使用定制的内核驱动转发控制命令,主机端使用vhost[42]后端驱动.

在数据路径上,当RDMA应用采用基于事件的通知机制时,采用加锁共享环形队列的方式,以减少通知的延迟.

由于HyV在具体实现上均需要定制的虚拟机和主机内核驱动,因此对RDMA驱动依赖较强,容器受限于具体的内核版本和网卡硬件.

vRDMA只适应于vSphere,而HyV则受限于具体版本的Linux系统.

为了支持HPC环境轻量级系统OSv的RDMA虚拟化,Fan等人提出了与HyV相似的轻量级框架virtio-RDMA.

客户机应用的RDMA请求直接从用户空间转发到主机,避免客户机中用户态到内核态的上下文切换,同时减少了对RDMA内核驱动模块的依赖.

此外,主机后端驱动还可以使用vhost-user[43].

该驱动位于用户空间,减少了用户和内核之间的切换次数.

对于同一主机的客户机通信,该框架采用共计算机系统应用http://www.

c-s-a.

org.

cn2020年第29卷第10期4专论综述SpecialIssue享内存的方式进行.

类似virtio-RDMA的还有Mouzakitis等人提出的轻量级的RDMA虚拟化框架[33],同样利用用户级别的API,避免对内核驱动的依赖.

不同的是,在控制路径上,主机和客户机之间采用共享内存方式来交互.

除了针对RDMA应用的虚拟化方案,王冬洋等人提出了针对socket应用的RDMA虚拟化框架vSocket,利用RDMA网络的高性能加速虚拟机之间的socket通信.

vSocket同样由前后端驱动组成,前端驱动中的用户库负责拦截Socket应用的API请求.

vSokcet针对socket通信中连接建立和数据传输做不同处理,为了保障安全性,连接建立过程通过重用原有的内核协议栈进行.

与HyV不同的是,当连接建立后,vSocket通过前后端驱动的半虚拟化框架进行数据传输,因为云环境中的网络往往需要主机对来自客户机的数据包进行封装或者对送往客户机的数据包进行解封,而RDMA网卡又不支持该功能,例如VXLAN等.

此外,vSokcet后端驱动直接面向主机Verbs接口,即数据再通过主机Verbs库进行传输,因此,vSocket具有一定的通用性,不像HyV依赖特定内核版本,维护困难等.

4.

2.

2容器环境随着容器技术的发展和流行,许多RDMA应用部署在轻量级的容器中.

针对虚拟机环境的RDMA虚拟化方案,如vRDMA和HyV等,并不适应于容器环境.

针对容器环境的RDMA虚拟化框架有FreeFlow等[34–36].

FreeFlow[34]在设计上和HyV十分类似,对RDMA的控制路径和数据路径分开处理.

FreeFlow在RDMA应用容器和底层RDMA驱动之间设计了一个路由层,该层由容器实现,负责接收来自RDMA应用容器的控制命令,并进行RDMA网络传输,实现对RDMA传输的管理和控制.

路由容器和RDMA应用容器之间通过共享内存实现RDMA传输数据的零拷贝.

如图4所示,FreeFlow的架构由3部分组成(图中灰色部分),分别是位于RDMA应用容器的网络库,路由容器,和网络编排器组成.

网络库负责为容器中的RDMA应用提供虚拟的与原生一致的Verbs接口.

在控制路径上,应用容器中的FreeFlow网络库通过套接字或共享内存的进程间通信方式转发命令和参数给路由容器.

每个主机上都有一个路由容器,和RDMA应用容器位于同一虚拟网络,路由容器可以直接访问RDMA网卡设备,并执行接收到的RDMA应用请求.

路由容器通过共享内存的方式获取RDMA应用数据并将网卡接收数据返回给RDMA应用,在数据路径上做到了零拷贝.

网络编排器负责容器IP的统一管理以及对RDMA网络传输的数据策略,例如QoS(QualityofService)或计费服务等.

图4FreeFlow框架FreeFlow适应于容器云计算环境,强调了对RDMA网络传输数据路径的控制,提供了数据的QoS和流量计费等策略.

但是,FreeFlow在虚拟化过程中,在RDMA的控制路径上带来了额外的开销,采用自旋轮询共享内存的方式需要占用CPU资源,而采用Socket通信会造成更高的延迟;在数据路径上,应用容器和路由容器通过共享内存实现零拷贝,也带来了一定的安全问题.

除了FreeFlow,Mellanox针对Linux命名空间和控制组机制,让多个容器可以共享同一个RDMA物理网卡[35,36].

该方案将物理RDMA网卡通过MACVLAN技术扩展为多个虚拟接口,每个容器可以使用一个或多个虚拟接口.

同时,对于QP,CQ等网卡资源采用更细粒度的控制组机制,容器可以直接使用硬件资源进行数据传输.

该方案虽然保障了隔离性,但是使用VLAN网络时,在容器迁移过程中需要更新路由信息,因此可移植性比较差.

另外,由于容器直接使用RDMA网卡进行数据传输,其控制性比FreeFlow要差.

4.

3纯软件模拟RDMA网络的普及程度比不上普通以太网.

在缺乏RDMA硬件的环境中,可以通过软件模拟的方法来实现RDMA通信.

在该方法中,RDMA设备的功能完全通过软件的方式得以实现,并向用户提供与原生一致的Verbs编程接口.

因此,无需依赖RDMA网卡、交换机等硬件设备.

RDMA软件模拟方案主要有SoftRocE[37]和Softi-WARP[38].

SoftRocE是一个软件辅助实现的RoCE-2020年第29卷第10期http://www.

c-s-a.

org.

cn计算机系统应用SpecialIssue专论综述5Linux驱动程序,用于在普通以太网上模拟RoCE网络.

而SoftiWARP是用于在以太网络上模拟iWARP网络的驱动程序.

在具体实现上,SoftRocE和SoftiWARP都可以分为用户层和内核层两个部分.

用户层用以支持上层RDMA应用,用户级库提供了与Verbs一致的接口.

内核层包含了可加载的内核模块,用以支持内核层次的应用.

SoftRoCE的内核模块利用UDP栈进行数据传输,而SoftiWARP则在TCP内核套接字之上运行.

SoftRoCE和SoftiWARP可以让缺乏RDMA硬件条件的大数据中心或云计算平台构建起可用的RDMA网络.

但是,由于软件模拟的方法基于TCP/UDP进行网络通信,它们的性能上受到限制,在吞吐量和延迟上和传统的以太网TCP/UDP通信较为接近,和原生RDMA网络通信的性能差距较大.

此外,SoftRoCE或SoftiWARP由于包含内核模块,也受限于特定版本的Linux系统.

因此,SoftRoCE和SoftiWARP主要用于测试、应用开发以及缺乏RDMA硬件却需要部署RDMA应用的环境.

4.

4评价目前,RDMA的虚拟化方案主要可以分为硬件辅助和软件辅助的方案.

虚拟机环境下,软件辅助的虚拟化方案可以细分为半虚拟化(例如vRDMA和vSocket)和混合虚拟化(例如HyV和virtio-rdma等),两者主要区别在于RDMA数据路径是否绕过主机监视器或内核.

容器环境下,主要有FreeFlow等虚拟化框架.

此外,在缺少RDMA硬件条件的场景下,可以用SoftiWARP或SoftRoCE来模拟RDMA网络.

RDMA虚拟化的目标是既保证网络的高性能,同时也不损失云环境的特点.

因此,对于上述方案的虚拟化效果,我们从RDMA网络性能与云环境特点这两个方面进行讨论.

针对RDMA网络性能,主要考虑延迟,吞吐量和CPU负载这3个指标.

针对云环境,则从隔离性,可移植性,控制性3个维度来讨论.

其中:(1)隔离性:每个虚拟机或容器实例都有其专属的RDMA网络资源,不与其他实例冲突.

(2)可移植性:虚拟机或容器实例迁移管理的便捷程度.

例如,虚拟机的快照和迁移,容器的迁移等.

(3)控制性:RDMA虚拟化方案对于RDMA网络传输的控制,例如流量限制,流量计费和QoS等.

针对RDMA网络性能,硬件辅助的虚拟化方案由于没有软件虚拟层的额外开销,所以延迟和吞吐量可以与原生RDMA相当.

但是SR-IOV需要更多的CPU负载来处理网卡中断以保证网络性能.

软件辅助虚拟化一般将控制路径和数据路径分别处理.

在数据路径上,像HyV,virtio-RDMA和FreeFlow等框架通过内存映射或共享内存实现了零拷贝,因此,延迟和吞吐量较好,像传统半虚拟化方案的vRDMA和vSocket等,其数据需要经过监视器或主机内核,因而延迟较高.

在控制路径上,通过共享内存的方式交互延迟更低,但依赖CPU轮询,通过套接字等转发的方式则可以减少CPU负载,但延迟更高.

针对云环境特点,硬件辅助的虚拟化方案往往难以达到所有的维度,例如,容器与SR-IOV网卡VF设备的IP绑定而不能灵活迁移.

软件辅助的虚拟化方案中,混合虚拟化HyV等没有对数据路径进行统一控制,因而难以实现云环境下的网络限速,QoS等数据策略,FreeFlow则通过对数据路径的控制改进了这些不足.

纯软件模拟的方式,由于没有硬件限制,容易具备云环境下的各个特点.

由于RDMA技术的多样性以及RDMA虚拟化应用场景和实现平台的差异性,本文选择定性分析,分别从上述七个维度对不同虚拟化方案进行评估,其中每个维度定性地分为差,较差,较好,好四个级别,以尽可能体现出不同方案在各个维度上的差异.

各RDAM虚拟化方案的评估结果如表1所示.

表1RDMA虚拟化方案评估表方案代表传输延迟吞吐量CPU负载隔离性可移植性控制性设备直连—低高低好差差SR-IOV—较低较高较低好较差差软件模拟SoftRoCE,SoftiWARP高低高好好好半虚拟化vRDMA,vSocket较高较低较高较好好好混合虚拟化HyV,virtio-RDMA较低较高较低较好较好较差容器环境FreeFlow较低较高较高较好好好5展望目前,针对不同的云计算环境,有不同的RDMA虚拟化解决方案.

例如,针对虚拟机环境的vRDMA和HyV、针对容器环境的FreeFlow、针对普通以太网环境的SoftiWARP和SoftRoCE以及基于硬件的SR-IOV虚拟化等.

我们对以后的RDMA虚拟化技术研究做出了以下展望:计算机系统应用http://www.

c-s-a.

org.

cn2020年第29卷第10期6专论综述SpecialIssue(1)通用性:通用性包含针对不同RDMA网络的通用性以及针对不同云计算环境的通用性.

目前,最新的RDMA网络虚拟化方案都考虑到了对不同RDMA网络的通用性,例如HyV和FreeFlow都支持3种不同的RDMA网络.

但是,对于不同云计算环境,例如不同虚拟方式(容器或虚拟机),不同的操作系统等,还没有通用的RDMA解决方案.

通用的RDMA虚拟化方案,有利于统一部署,对RDMA应用统一管理,能适用于复杂的云计算环境.

(2)安全性:RDMA原生的通信模式和流程是安全的,但是不同的虚拟化方案可能会引入不同程度的通信安全问题.

通过软件辅助的RDMA虚拟化网络,如FreeFlow,HyV等,在转发控制命令的过程中可能被恶意劫持;通过硬件辅助的方案和纯软件模拟方案在通信方式上与原生RDMA没有区别.

因此,可以尝试通过额外的安全流程来弥补虚拟化中的安全漏洞,保证RDMA通信安全.

(3)编排管理:无论是使用RDMA应用的虚拟机,还是容器,在云计算环境中都需要管理或编排.

编排管理的目的:通过管理调度来高效利用集群的RDMA网卡资源,提高整个集群的运行效率,实现负载均衡等.

RDMA网卡作为重要的网络资源,在如Kubernetes之类的容器编排工具里面如何调度管理,这是一个值得不断研究优化的方向.

而在虚拟机环境中,直接使用SR-IOV技术会导致主机无法对虚拟机使用的RDMA资源进行统一管理,即便在使用类似HyV的软件辅助的虚拟化方法时,虚拟机无法完全感知主机RDMA资源,因此也需要思考如何对主机的RDMA资源进行高效动态的分配.

(4)嵌套虚拟环境:在实际应用中,许多RDMA应用容器并非部署于裸机,而是分布于虚拟机中.

此外,还有虚拟机的嵌套.

在这些复杂的嵌套虚拟环境下,如何使RDMA虚拟化,让最内层的虚拟环境同样能够利用到RDMA网络的高性能,也是需要考虑的问题.

(5)智能网卡:智能网卡或FPGA应用越来越广泛,已有一些研究将其应用到RDMA网络虚拟化[33],协助CPU处理网络负载.

与传统网卡相比,智能网卡可以处理更加复杂的网络负载并支持可替换的数据平面.

在RDMA虚拟化方案中,也可以思考如何与智能网卡的可编程功能高效结合,以提高云环境下的RDMA网络性能.

参考文献WangZG,LiuR,ChenYF,etal.

COREMU:Ascalableandportableparallelfull-systememulator.

Proceedingsofthe16thACMSymposiumonPrinciplesandPracticeofParallelProgramming.

SanAntonio,TX,USA.

2011.

213–222.

[doi:10.

1145/2038037.

1941583]1SongCH,WangWW,YewPC,etal.

Unleashingthepoweroflearning:Anenhancedlearning-basedapproachfordynamicbinarytranslation.

Proceedingsofthe2019USENIXAnnualTechnicalConference.

Renton,WA,USA.

2019.

77–89.

2FangZM,MinQH,ZhouKY,etal.

Transformer:Afunctional-drivencycle-accuratemulticoresimulator.

ProceedingsofDACDesignAutomationConference2012.

SanFrancisco,CA,USA.

2012.

106–114.

[doi:10.

1145/2228360.

2228381]3ZhangWH,JiXF,LuYP,etal.

Prophet:Aparallelinstruc-tion-orientedmany-coresimulator.

IEEETransactionsonParallelandDistributedSystems,2017,28(10):2939–2952.

[doi:10.

1109/TPDS.

2017.

2700307]4WangHJ,MinQH,LiY,etal.

RPSim:Arapidprototypingfull-systemsimulatorforSoCsoftwaredevelopment.

20149thIEEEInternationalConferenceonNetworking,Architecture,andStorage.

Tianjin,China.

2014.

259–267.

[doi:10.

1109/NAS.

2014.

45]5ZhangWH,WangHJ,LuYP,etal.

Aloosely-coupledfull-systemmulticoresimulationframework.

IEEETransactionsonParallelandDistributedSystems,2016,27(6):1566–1578.

[doi:10.

1109/TPDS.

2015.

2455499]6Docker.

https://www.

docker.

com/,2020.

[2020-04-18].

7rKt,asecurity-minded,standards-basedcontainerengine.

https://coreos.

com/rkt/,2020.

[2020-04-18].

8AbadiM,BarhamP,ChenJM,etal.

TensorFlow:Asystemforlarge-scalemachinelearning.

Proceedingsofthe12thUSENIXSymposiumonOperatingSystemsDesignandIm-plementation.

Berkeley,CA,USA.

2016.

265–283.

9RDMA-basedapachespark.

http://hibd.

cse.

ohio-state.

edu/,2020.

[2020-04-18].

10RDMA-basedapachehadoop.

http://hibd.

cse.

ohio-state.

edu/,2020.

[2020-04-18].

11PaddlePaddle.

https://github.

com/PaddlePaddle/Paddle.

[2020-03-09].

12Top500.

https://www.

top500.

org/statistics/list/.

[2020-03-09].

13IntroductiontoInfiniBandTM.

https://www.

mellanox.

com/pdf/whitepapers/IB_Intro_WP_190.

pdf,2010.

[2020-04-18].

14陈游旻,陆游游,罗圣美,等.

基于RDMA的分布式存储系统研究综述.

计算机研究与发展,2019,56(2):227–239.

152020年第29卷第10期http://www.

c-s-a.

org.

cn计算机系统应用SpecialIssue专论综述7[doi:10.

7544/issn1000-1239.

2019.

20170849]MitchellC,GengYF,LiJY.

Usingone-sidedRDMAreadstobuildafast,CPU-Efficientkey-valuestore.

Proceedingsofthe2013USENIXAnnualTechnicalConference.

SanJose,CA,USA.

2013.

103–114.

16LuYY,ShuJW,ChenYM,etal.

Octopus:AnRDMA-enableddistributedpersistentmemoryfilesystem.

Proceedingsofthe2017USENIXConferenceonAnnualTechnicalConference.

SantaClara,CA,USA.

2017.

773–785.

17WeiXD,ShiJX,ChenYZ,etal.

Fastin-memorytransactionprocessingusingRDMAandHTM.

Proceedingsofthe25thSymposiumonOperatingSystemsPrinciples.

Monterey,Canada.

2015.

87–104.

18DragojeviD,NarayananM,HodsonO,etal.

FaRM:Fastremotememory.

Proceedingsofthe11thUSENIXSympo-siumonNetworkedSystemsDesignandImplementation.

Berkeley,CA,USA.

2014.

401–414.

19Verbslibrary:Libibverbs.

https://www.

openfabrics.

org/downloads/libibverbs/,2011.

[2020-04-18].

20RoCEIntroduction.

http://www.

roceinitiative.

org/roce-intro-duction/,2020.

[2020-04-18].

21iWARP*RDMAhereandnow.

https://www.

intel.

com/content/dam/www/public/us/en/documents/technology-briefs/iwarp-rdma-here-and-now-technology-brief.

pdf,2019.

[2020-04-18].

22ZhangBB,WangXL,LaiRF,etal.

AsurveyonI/Ovirtual-izationandoptimization.

ProceedingsoftheFifthAnnualChinaGridConference.

Guangzhou,China.

2010.

117–123.

[doi:10.

1109/ChinaGrid.

2010.

54]23SinglerootI/Ovirtualization.

http://pcisig.

com/specifications/iov/single_root/,2020.

[2020-04-18].

24JoseJ,LiMZ,LuXY,etal.

SR-IOVsupportforvirtualiza-tiononinfinibandclusters:Earlyexperience.

Proceedingsofthe13thIEEE/ACMInternationalSymposiumonCluster,Cloud,andGridComputing.

Delft,theNetherlands.

2013.

385–392.

[doi:10.

1109/CCGrid.

2013.

76]25MuslehM,PaiV,WaltersJP,etal.

BridgingthevirtualizationperformancegapforHPCusingSR-IOVforInfiniBand.

Proceedingsofthe2014IEEEInternationalConferenceonCloudComputing.

Anchorage,AK,USA.

2014.

627–635.

[doi:10.

1109/CLOUD.

2014.

89]26TowardaparavirtualvRDMAdeviceforVMwareESXiguests.

http://download3.

vmware.

com/software/vmw-tools/papers/VMTJ_issue_2.

pdf,2020.

[2020-04-18].

27WangDY,FuBZ,LuG,etal.

vSocket:VirtualsocketinterfaceforRDMAinpublicclouds.

Proceedingsofthe15thACMSIGPLAN/SIGOPSInternationalConferenceon28VirtualExecutionEnvironments.

Providence,RI,USA.

2019.

179–192.

[doi:10.

1145/3313808.

3313813]王冬洋.

公有云中高性能网络系统研究[博士学位论文].

合肥:中国科学技术大学,2019.

29PfefferleJ,StuediP,TrivediA,etal.

AhybridI/Ovirtualiza-tionframeworkforRDMA-capablenetworkinterfaces.

Proceedingsofthe11thACMSIGPLAN/SIGOPSInterna-tionalConferenceonVirtualExecutionEnvironments.

Is-tanbul,Turkey.

2015.

17–30.

[doi:10.

1145/2731186.

2731200]30PfefferleJ.

vVerbs:AparavirtualsubsystemforRDMA-capablenetworkinterfaces[Master'sthesis].

Zurich,Switzer-land:ETHZurich,2014.

31TowardsaLightweightRDMAPara-VirtualizationforHPC.

https://mediatum.

ub.

tum.

de/doc/1344417/1344417.

pdf,2020.

[2020-04-18]32MouzakitisA,PintoC,NikolaevN,etal.

LightweightandgenericRDMAenginepara-virtualizationfortheKVMhy-pervisor.

Proceedingsof2017InternationalConferenceonHighPerformanceComputing&Simulation.

Genoa,Italy.

2017.

737–744.

[doi:10.

1109/HPCS.

2017.

112]33KimD,YuTL,LiuHH,etal.

FreeFlow:Software-basedvirtualRDMAnetworkingforcontainerizedclouds.

Pro-ceedingsofthe16thUSENIXConferenceonNetworkedSystemsDesignandImplementation.

Boston,MA,USA.

2019.

113–126.

34ContainingRDMAandhighperformancecomputing.

http://caxapa.

ru/thumbs/808632/containing_rdma_final.

pdf,2020.

[2020-04-18].

35RDMAcontainersupport.

https://downloads.

openfabrics.

org/Media/Monterey_2015/Tuesday/tuesday_08.

pdf,2020.

[2020-04-18].

36SoftRoCE:SoftwareRDMAoverConvergedEthernet.

https://github.

com/SoftRoCE,2017.

[2020-04-18].

37Softiwarp.

https://www.

openfabrics.

org/downloads/Media/Sonoma2009/Sonoma_2009_Mon_softiwrp.

pdf,2020.

[2020-04-18].

38VMwarevSphere.

https://www.

vmware.

com/products/vsphere.

html,2020.

[2020-04-18].

39KVM.

http://www.

linux-kvm.

org/index.

phptitle=Main_Page&oldid173792.

(2016-11-07)[2020-03-09].

40Virtio.

http://www.

linux-kvm.

org/index.

phptitle=Virtio&oldid173787.

(2016-10-12)[2020-03-09].

41UsingVhost.

http://www.

linux-kvm.

org/index.

phptitle=UsingVhost&oldid3513.

(2011-03-08)[2020-04-18].

42Vhost-user.

https://wiki.

qemu.

org/Features/VirtioVhostUser.

(2018-02-06)[2020-04-18].

43计算机系统应用http://www.

c-s-a.

org.

cn2020年第29卷第10期8专论综述SpecialIssue

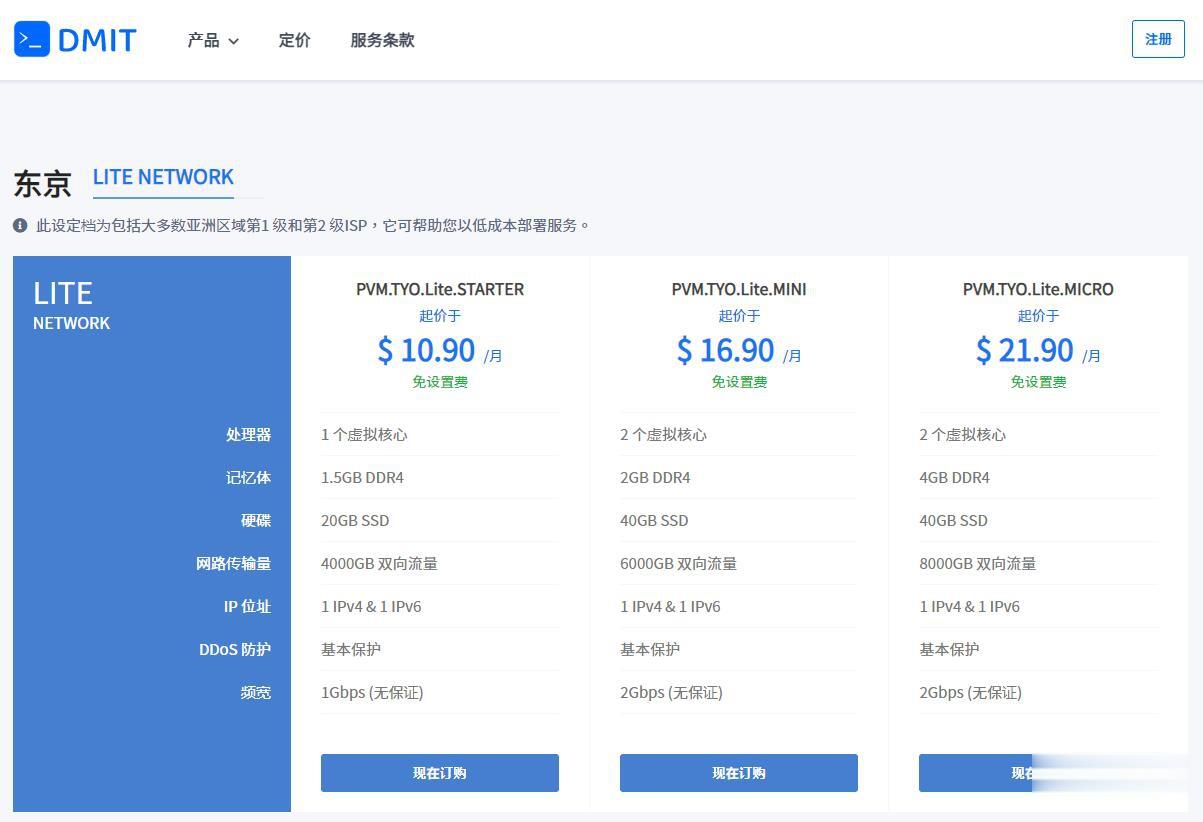

DMIT$10.9/月,日本VPS/三网直连/1核1.5G内存/20GB存储/1Gbps端口

优惠码年付一次性5折优惠码:TYO-Lite-Open-Beta-1y-50OFF永久8折优惠码:TYO-Lite-Open-Beta-Recur-20OFF日本vpsCPU内存SSD流量带宽价格购买1核1.5G20 GB4 TB1Gbps$10.9/月购买2核2 G40 GB6 TB1Gbps$16.9/月购买2核4 G60 GB8 TB1Gbps$21.9/月购买4核4 G80 GB12 TB...

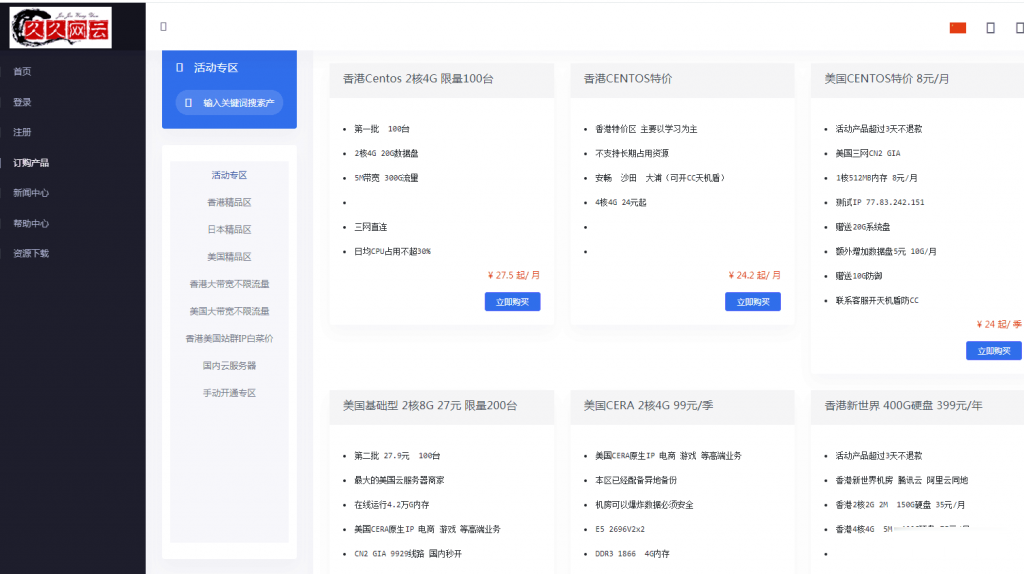

久久网云-目前最便宜的国内,香港,美国,日本VPS云服务器19.9元/月起,三网CN2,2天内不满意可以更换其他机房机器,IP免费更换!。

久久网云怎么样?久久网云好不好?久久网云是一家成立于2017年的主机服务商,致力于为用户提供高性价比稳定快速的主机托管服务,久久网云目前提供有美国免费主机、香港主机、韩国服务器、香港服务器、美国云服务器,香港荃湾CN2弹性云服务器。专注为个人开发者用户,中小型,大型企业用户提供一站式核心网络云端服务部署,促使用户云端部署化简为零,轻松快捷运用云计算!多年云计算领域服务经验,遍布亚太地区的海量节点为...

美国云服务器 1核 1G 100M 10G防御 39元/月 物语云计算

物语云计算(MonogatariCloud)是一家成立于2016年的老牌国人商家,主营国内游戏高防独服业务,拥有多家机房资源,产品质量过硬,颇有一定口碑。本次带来的是美国圣何塞 Equinix 机房的高性能I9-10980XE大带宽VPS,去程CN2GIA回程AS9929,美国原生IP,支持解锁奈飞等应用,支持免费安装Windows系统。值得注意的是,物语云采用的虚拟化技术为Hyper-V,资源全...

上网卡设备为你推荐

-

http://www.huajinsc.cn/支持ipadcss3圆角在HTML里如何实现圆角矩形?勒索病毒win7补丁怎么删除 防勒索病毒 打的补丁x-routerX-Router这个软件有什么用canvas2Canvas ~セピア色のモチーフ~ 这个动画片的中文翻译是什么?从哪看?ms17-010win10华为 slatl10是什么型号google中国地图谷歌卫星地图中文版下载在哪下??icloudiphone没开启icloud的iphone怎么用find my iphone找回micromediaMacromedia Fireworks 8是什么东西,怎么用?